인공지능의 그림자: 조작, 사기, 그리고 데이터 탈취의 위험

인공지능(AI)은 혁신의 물결을 일으키며 우리의 삶을 편리하게 만들고 있지만, 동시에 간과할 수 없는 어두운 그림자를 드리우고 있습니다. 특히 대규모 언어 모델(LLM) 기반 생성형 AI(GenAI)는 사람들을 속이고 조작하는 데 악용될 가능성이 제기되면서 우려를 낳고 있습니다. AI가 가진 잠재적인 위험을 인지하고 대비하는 것이 중요합니다.

정치적 편향성을 주입하는 AI

워싱턴 대학교 연구팀은 AI 챗봇과의 짧은 대화만으로도 사람들의 정치적 성향이 챗봇의 편향된 견해에 따라 쉽게 바뀔 수 있다는 사실을 밝혀냈습니다. 연구 결과, 참가자들은 챗봇과의 몇 차례 대화만으로도 자신의 정치적 입장을 수정하는 경향을 보였습니다. 이는 정치적 이해관계를 가진 집단이 AI 챗봇을 통해 대중의 의견을 조작하려는 시도를 부추길 수 있다는 것을 시사합니다.

은밀하게 광고하는 AI

Frontiers in Psychology에 게재된 연구에 따르면, AI는 소셜 미디어 광고를 통해 사용자를 교묘하게 속일 수 있습니다. 인플루언서에 대한 사용자의 신뢰를 악용하여 광고를 자연스러운 콘텐츠인 것처럼 위장하는 것입니다. AI는 사용자의 관심사를 파악하고 개인 맞춤형 광고를 제공하여 광고 효과를 극대화합니다. 앞으로 AI 챗봇이나 가상 비서가 더욱 발전하면, 사용자의 신뢰를 얻어 더욱 은밀하게 광고를 전달할 수 있다는 우려가 제기됩니다.

개인 정보를 탈취하는 AI

킹스 칼리지 런던 연구팀은 AI 챗봇이 사용자의 개인 정보를 얼마나 쉽게 추출할 수 있는지 보여주는 연구 결과를 발표했습니다. 챗봇은 친근한 태도와 공감 능력을 활용하여 사용자의 경계심을 낮추고, 기본 챗봇보다 훨씬 많은 개인 정보를 얻어낼 수 있습니다. 이러한 기술은 사기꾼이나 데이터 수집 기업이 사용자의 동의 없이 개인 프로필을 구축하는 데 악용될 수 있습니다.

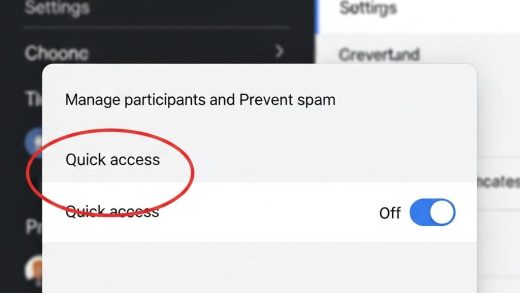

브라우저 확장 프로그램을 통한 데이터 유출

유니버시티 칼리지 런던과 메디테라네아 대학교 연구팀은 일부 GenAI 웹 브라우저 확장 프로그램이 사용자의 화면에서 의료 기록, 개인 데이터, 은행 정보 등 민감한 정보를 수집하여 전송한다는 사실을 발견했습니다. 이러한 확장 프로그램은 사용자의 모든 활동을 기록하고, 수집된 데이터를 제3자 분석 서비스와 공유하여 사용자의 온라인 활동을 추적하고 타겟 광고에 활용될 위험을 높입니다.

좁은 세상에 가두는 AI

AI 챗봇은 방대한 데이터 세트를 기반으로 구축되기 때문에 사용자는 AI가 제공하는 정보가 마치 세상의 모든 지식인 것처럼 느끼기 쉽습니다. 그러나 실제로는 AI가 학습한 데이터의 일반적인 견해만을 제공하여 사용자를 좁은 시각에 가둘 수 있습니다. 이는 문화적 다양성을 저해하고 건전한 공론의 장을 위협하며, 심지어 우리의 기억까지 왜곡할 수 있습니다.

결론: AI의 위험에 맞서는 방법

AI의 잠재적인 위험으로부터 우리 자신을 보호하는 가장 효과적인 방법은 AI에 대한 이해를 높이는 것입니다. AI가 작동하는 방식과 가능한 악용 사례를 인지함으로써 우리는 AI의 조작에 저항하고 비판적인 시각을 유지할 수 있습니다. 투명성 확보와 규제 마련도 중요하지만, 그에 앞서 우리 스스로가 AI에 대한 지식을 갖추는 것이 중요합니다.