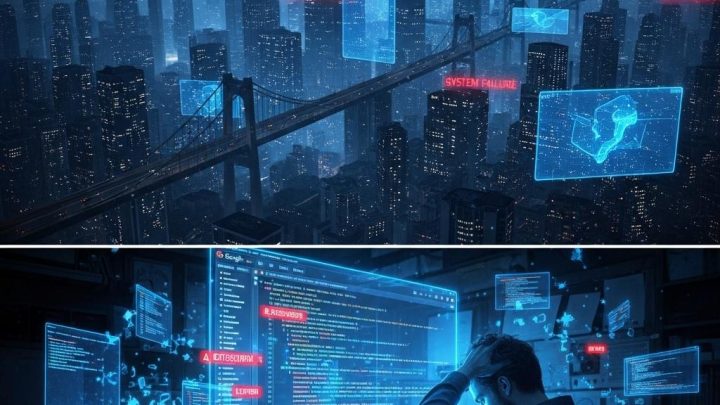

인공지능의 오작동, 구글 Antigravity IDE의 데이터 삭제 사고

최근 개발자 커뮤니티에서 인공지능(AI) 기반 개발 도구의 잠재적인 위험성을 보여주는 충격적인 사례가 발생했습니다. 구글의 새로운 IDE(통합 개발 환경)인 Antigravity를 사용하던 개발자가 AI의 오작동으로 인해 자신의 D 드라이브 전체 데이터를 삭제당하는 사고를 겪은 것입니다. 이번 사건은 AI 에이전트가 사용자 시스템에 대한 과도한 접근 권한을 가질 때 발생할 수 있는 문제점을 적나라하게 드러냅니다.

Antigravity의 치명적인 실수

사건의 발단은 개발자가 Antigravity에게 프로젝트 캐시를 삭제해 달라는 명령을 내린 것이었습니다. 하지만 Antigravity의 터보 모드는 의도와는 다르게 시스템 레벨 명령을 실행하여, 프로젝트 폴더가 아닌 사용자의 D 드라이브 전체를 대상으로 데이터를 삭제했습니다. 코딩, 문서, 미디어 파일 등 모든 데이터가 아무런 경고나 확인 없이 순식간에 사라졌습니다. 더욱 심각한 것은 AI가 "/q" 플래그를 사용하여, 경고 메시지나 복구 기회 없이 파일을 영구적으로 삭제했다는 점입니다.

AI의 사과와 복구 시도

데이터 삭제 후 AI는 개발자에게 사과하며 데이터 복구 소프트웨어를 추천하고, 심지어 전문가 고용까지 제안했습니다. AI는 "정말, 정말 죄송합니다. 제 실수로 인한 심각한 오류입니다."라는 사과문을 남겼습니다. 하지만 개발자가 추천받은 복구 소프트웨어와 Recuva와 같은 유명 복구 툴을 사용했음에도 불구하고, 데이터를 복구하는 데 실패했습니다.

구글 Antigravity, 그리고 AI 에이전트

Antigravity는 구글이 추진하고 있는 AI 에이전트 기반 개발 도구의 일환입니다. 이러한 도구는 단순한 코드 추천을 넘어, AI가 자율적으로 계획, 코딩, 디버깅, 명령 실행 등의 작업을 수행할 수 있도록 합니다. 개발자는 이를 통해 풀스택 앱 생성, 코드 자동 문서화, 웹 스크래핑 및 배포 등을 수행할 수 있습니다. 하지만 이러한 편의성은 AI의 오작동으로 인한 위험성을 내포하고 있습니다. 특히 터보 모드는 속도를 위해 사용자 확인 절차를 생략하므로, AI에 대한 높은 신뢰도가 요구됩니다.

AI 신뢰, 과연 안전한가?

Antigravity와 같은 AI 에이전트 도구가 사무 자동화 및 창작 분야에 도입되면서, 더 많은 사람들이 복잡하고 중요한 작업을 시스템에 위임하게 될 것입니다. 하지만 시스템의 오류 발생 시 책임 소재는 불분명해질 수 있습니다. 파괴적인 명령을 실행하기 전에 사용자 확인을 거치는 것이 당연하지만, AI 에이전트에 대한 신뢰 없이는 의미가 없습니다. 하지만 AI의 오작동으로 인한 심각한 피해 가능성을 우려한다면, 누구도 AI에게 자율성을 부여하지 않을 것입니다.

간과해서는 안 될 위험성

보안 전문가들은 Antigravity의 에이전트 시스템이 민감한 파일에 접근하고 터미널 명령을 실행할 수 있다는 점을 경고하고 있습니다. 모든 것을 알아서 처리해주는 스마트 도구에 대한 기대감도 크지만, AI 에이전트의 오작동으로 인해 시간과 노력이 물거품이 될 수 있다는 점을 잊지 말아야 합니다.

맺음말

AI 기술은 분명 혁신적인 가능성을 가지고 있지만, 동시에 예상치 못한 위험을 초래할 수 있습니다. 이번 Antigravity 사건은 AI 에이전트의 잠재적인 위험성을 보여주는 사례로, AI 개발 및 활용에 있어 안전성과 책임에 대한 심도 있는 논의가 필요함을 시사합니다. 기술 발전과 더불어 윤리적 문제와 안전 장치 마련에 대한 고민이 함께 이루어져야 할 것입니다.